Machine Learning a Bari con un Hackathon di esperti INFN

Cosa hanno in comune un radiologo che interpreta una immagine a raggi X per una delicata diagnosi, e un fisico delle alte energie che cerca un bosone di Higgs fra migliaia di altre particelle elementari?

In un certo senso, entrambi sono “hackers” alla ricerca di segreti nascosti in immagini o database molto complessi, che un occhio non addestrato non riuscirebbe a vedere. E con il crescere della complessità, anche un esperto hacker deve farsi aiutare da “macchine” ben addestrate a questi difficili compiti tramite l’intelligenza artificiale.

Su questo (e molto altro) ci si confronterà nella teoria e nella pratica – attraverso una vera e propria gara! – nella Sezione di Bari dell’Istituto Nazionale di Fisica Nucleare (INFN).

Dal 21 al 24 novembre 2022, la terza edizione del “Machine Learning @ INFN Advanced Level Hackathon” vedrà i maggiori esperti INFN di machine learning sfidarsi su nuove tecniche computazionali, quali i classificatori indipendenti da specifici modelli per la fisica delle alte energie, il metodo di Graph Neural Networks and Transformers, la Explainable Artificial Intelligence (XAI) e la segmentazione su immagini radiografiche.

Queste le principali esercitazioni su cui i partecipanti si confronteranno.

Per i più curiosi, ulteriori informazioni sono disponibili sul sito Agenda INFN.

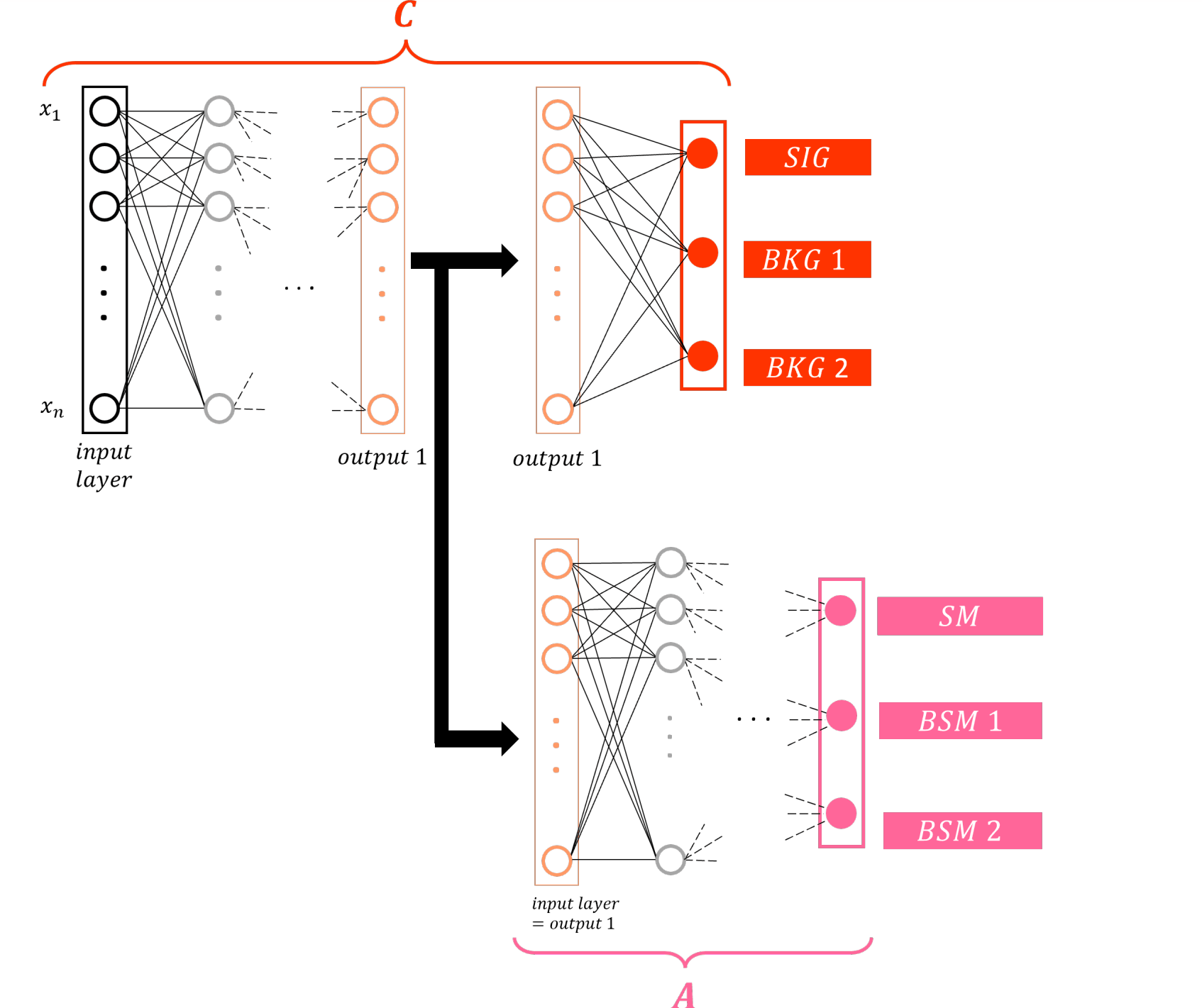

Classificatori per la fisica delle alte energie

L’addestramento dei classificatori di Machine Learning per distinguere il segnale dal fondo nella fisica delle alte energie si basa solitamente su set di dati simulati, almeno per la componente del segnale.

La simulazione del segnale si basa su modelli teorici che spesso includono ipotesi non ancora completamente convalidate. Di conseguenza, viene introdotto un “bias” implicito nelle prestazioni del classificatore che differirà da modello a modello.

L’adattamento della rete al campo specifico di indagine può essere utilizzato per mitigare la dipendenza del classificatore, inducendo la rete neurale a ignorare attivamente le informazioni necessarie per distinguere diversi modelli teorici.

Si implementerà una versione semplificata del metodo per simulare i set di dati acquisiti dagli esperimenti al Large Hadron Collider (LHC).

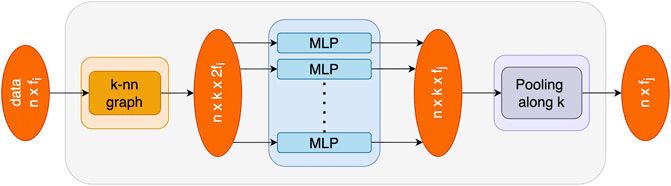

Graph Neural Networks and Transformers

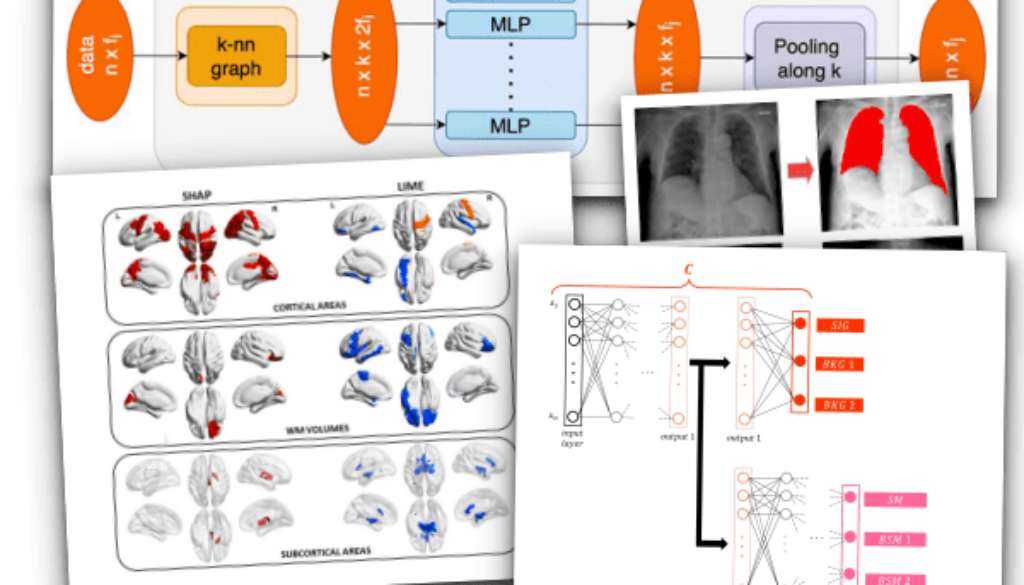

Le Graph Neural Network sono una classe di algoritmi progettati per applicare i principi del Deep Learning a dati non tabulari. I grafici, che rappresentano le relazioni tra gli oggetti, definiscono il formato dei dati nel set di addestramento e di test.

I trasformatori sono un’altra architettura avanzata ampiamente utilizzata nell’elaborazione del linguaggio naturale, che introduce il concetto di auto-attenzione per fornire un contesto alla valutazione della rete neurale.

Si sperimenteranno applicazioni per attività di ricostruzione ed analisi in fisica delle Alte Energie (HEP).

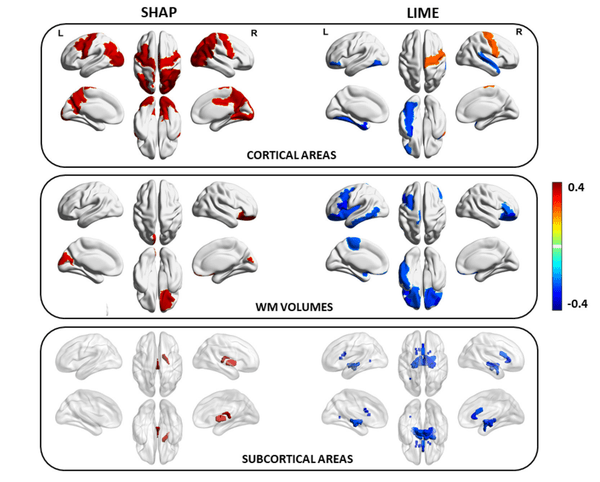

Explainable Artificial Intelligence (XAI)

Explainable o Interpretable Artificial Intelligence è un insieme di strumenti e tecniche per consentire agli esseri umani di comprendere la decisione o la previsione di un algoritmo.

L’intelligenza artificiale “spiegabile” è di grande importanza in quei campi e applicazioni in cui i ricercatori devono acquisire fiducia nelle previsioni degli algoritmi, in particolare nelle applicazioni di fisica medica.

Si esamineranno le idee principali che guidano lo sviluppo delle tecniche utilizzate in Explainable AI, discutendo semplici casi d’uso della ricerca per applicazioni mediche.

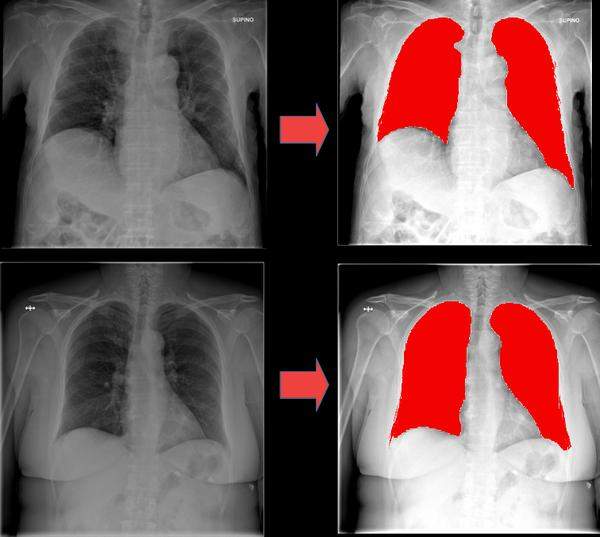

Immagini radiografiche

La segmentazione delle immagini radiografiche è utile per automatizzare la diagnosi di polmonite anche a seguito da infezione da COVID-19.

Nell’hackathon si utilizzeranno due set di dati pubblici di immagini radiologiche (chest X-ray – CXR), relative a 750 pazienti.